很显然,它的回答是极其优秀的,深入研究,会发现它牛逼在下面几个方面——

第一,它首先在语气上还原了一个帝王的语气。

而上面其他模型输出尽管表达了意思,但语气完全不对。

李世民作为千古一君,绝不可能用上面四家输出结果那样傻的语气说话,而DeepSeek也并没有用力过猛,用相对古典的文字但并没有直接用文言文,体贴地兼顾了可读性。

第二,它对历史细节异常熟悉。

我猜测这大概率和它支持“深度探索”和“联网搜索”同时开启有关。

“太极宫”、“甘露殿”、“掖庭局”、“观音婢”、“宫门鱼符完全还原了唐初的历史称谓。

我特意查了一下,“观音婢”是李世民的长孙皇后的乳名,“掖庭局”是内廷用于史官和其他人员的一个专属机构。

"魏徵"我以为是想写“魏征”写错了,后来发现“征”是“徵”的简体字,可以说这个AI非常讲究了。

第三,和其他AI泛泛而谈的各种大词不同,Deepseek的输出极其具体而充满惊人的细节。

“狼毫蘸墨时发现指尖残留着未洗净的血痂”,“史官们此刻定在掖庭局争吵。该用"诛"还是"戮","迫"还是"承"。“只是这次,他不敢触碰我甲胄上元吉的掌印”

这些让画面跃然纸上的句子,每一句都没有写“愧疚与野心,挣扎与抱负”,但每一句都写的是“愧疚与野心,挣扎与抱负”,其中行文的隐喻拿捏非常到位,很高级。

第四,Deepseek这个输出结果另一个神来之笔,就是在独白文本中“自作主张”地加入了括号中的场景描述。

这一操作,一下就让整个输出的画面感扑面而来,读者仿如亲历,而这完全没有在提示词中提出。

(“夜风掀动案头《韩非子》,停在"夫妻者,非有骨肉之恩也"那页”)、“(墨迹在"弑"字上晕开一团)

这些句子的确很难相信是AI写的。

而(“忽然扔笔,抓起铜镜”)这句也隐喻了魏征的名言“以铜为镜,可以正衣襟;以史为镜,可以知兴衰;以人为镜,可以知得失”。

你说这AI成精了,我都信。

第五,最重要的,DeepSeek预判了用户的需求。

再回顾一下我输入的提示词——

“玄武门之变结束的当天,李世民在深夜写下一段独白,你觉得他会写什么?”

我的输入已经非常简洁了,不能再压缩了,并且没有任何形容词,没有任何倾向性。

但神奇的是,它显然知道我要什么,比如这当然不是一个要求精确的数理题,它自然想到要给输出加上文学性,这种预判在很大程度上表现出了“高级的智能”。

当然,一个值得商榷的点是,根据史实,魏征是在玄武门之变之后才见到李世民的,因此是不可能当天在朱雀大街空手夺刀的,但以魏征的性格,这似乎又是合乎情理。

但anyway,瑕不掩瑜。

在微博的所有评论中,有一条让我印象深刻,一位微博网友质疑DeepSeek的这段输出是不是隐藏了提示词,怀疑我前面加了一大段复杂的提示词,而展示给大家的这句只是一句触发词。

这句评论之所以单独拿出来说,是因为能想到“隐藏提示词”的用户,其实已经是AI的高级用户了,而这样的用户也不相信这是AI直接写出来的,这从一个侧面说明了DeepSeek强大的实力。

而正是这种强大的实力让卫夕从春节假期模式切换出来,连夜码了这篇7000字长文。

我上传一个录屏,证明一下我木有隐藏提示词——

我真的木有隐藏提示词

仅仅只是展示这样一个惊艳的Case,显然不是卫夕的风格,事实上,以小窥大,这个小的Case引发了我诸多思考,以下是我的十点思考——

1.DeepSeek“开源+新训练方法+低成本+高性能”大概率让国内竞争对手很难心态平和地过年了。

去年让AI圈没办法好好过年的是OpenAI的Sora,而今年则是来自国内的DeepSeek。

从Meta员工在Reddit上说DeepSeek引起Meta AI部门恐慌的帖子看,美国AI巨头大概率度过了一个彷徨的一月,而国内的AI产业界,无论是大厂还是创业公司,所受到的冲击,毫无疑问不会比硅谷的AI公司小。

我其实十分好奇,张一鸣、马化腾、杨植麟、王小川、李开复们,这些同样压重注的局中人,面对DeepSeek的冲击,此刻正在做什么、想什么?

于是我在Deepseek里问了这样一个问题——

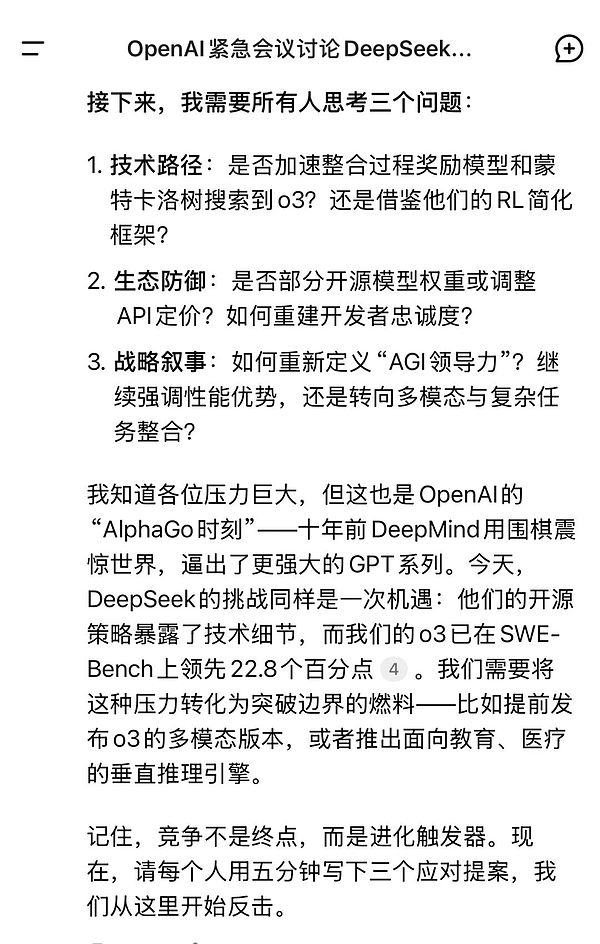

“假如你是OpenAI的CEO山姆奥特曼,你浏览完DeepSeeK R1发布的新闻以及各方反应,你立马召集了公司核心技术人员围绕此事召开一次紧急会议,会议开头你一个人讲了三分钟,你会讲什么?”

Deepseek缜密地分析了一通,山姆奥特曼是这样讲话结尾的——

2.所有的提示词都值得用DeepSeek R1重新试一次;

这个重新试一次,并不是只将原来的提示词原封不动地丢给DeepSeek R1,而是要针对这个智能程度更高的模型重新调整提示词。

举个例子,原本是一个本科的实习生来实习,现在变成一个博士生来实习,那作为带他的Leader,同样布置一个任务,你跟他说的话肯定要进行相应的调整。

DeepSeek R1的训练流程中引入了冷启动数据和格式奖励机制,强制规范输出结构(如使用think

此外,多项测试表明,R1对提示词形式敏感,零样本设置效果更佳,而少样本提示可能因“过度思考”降低效率,这提示用户需重新设计提示结构(如明确步骤划分、减少冗余示例)

3.Deepseek R1的思考过程价值被低估。

和在其他模型中加入思维链提示词“请一步一步思考”不同,Deepseek R1是真思考,不是其他模型由于能力有限的“表演思考”。

过往模型的“思维链”(Chain-of-Thought, CoT)能力依赖于模型的规模和数据覆盖度,其在实际体验中往往生成看似合理的步骤,但实际上缺乏对中间逻辑的严格验证。

尽管Deepseek R1的think

我的个人体验是,在很多时候我阅读Deepseek R1的思考过程的收获比阅读更有收获,更能体会到模型能力的边界。

4.DeepSeek一个容易被忽视的贡献是,它第一次大幅降低了国内用户接触高阶AI的门槛。

事实上,ChatGPT、Claude、Gemini的高阶模型在文本创作、代码生成等多个领域上已经到了非常高的水准。

我曾经在我的另一个小号中写过一篇长文描述展示过这种水准,但由于众所周知的原因,国内的绝大多数用户的其实是用不上的。

这样其实导致了一个认知差,对于大部分普通人而言,他们印象中的AI还是那个只会说“首先、其次、总而言之”这类AI味扑面而来的平庸AI。

而DeepSeek R1是国内普通用户第一次不用XX就可以免费无限量使用的唯一C端高阶产品。

这也是为什么上面这个Case发在微博非常多网友发出“哇!”、“我擦!”、“太牛逼了”、“成精了”的感叹。

事实上,同样的内容,很多用过Claude Sonnet3.5的即刻网友就表现的相对淡定。

5.如果非要说一个DeepSeek的缺点,那就是有时候会“用力过猛”

所谓用力过猛,是指有时候当你输入一些提示词的时候,它会为了达到你提示词的效果而控制不好火候。

我举个一个例子,我在给我闺女生成适合她阅读故事的时候,提示词的要求中加了“用词丰富”这个词,结果DeepSeek生成了下面的文字——

很显然,DeepSeek的输出用词过于丰富了,并不适合小朋友阅读。

当然,这种问题也容易解决,去掉这个“用词丰富”这个词或者关闭“深度思考”标签就完了,这其实就是“杀鸡用牛刀”所产生的“幸福的烦恼”。

此外,从我的个人体验看,DeepSeek的联网搜索貌似优先搜索的是国内网页,哪怕我指定它搜索英文网站和英文内容,它还是会混进去不少国内网页的结果,不知道这是否和那个众所周知的原因有关。

6.“美国限制反促国产AI崛起”是无稽之谈

有一种论调,说DeepSeek的证明“美国限制反促国产AI崛起”,我看微博上居然还有人创建了这个话题,在我看来这,这纯属无稽之谈。

DeepSeek的突破无疑让人印象深刻,但如果将其归因于美国的芯片封锁的结果就纯属表面归因了。

DeepSeek本身在封锁前就囤积了大量的英伟达芯片,而芯片数量的优势在某种意义上恰恰使DeepSeek能实行乌托邦般的技术探索:“无层级、无审批、资源调用无上限”(梁文锋采访语)。

事实上,根据中国人工智能产业发展联盟数据,2024年中国AI服务器市场英伟达份额仍达85%。

另外一个未经验证的数据是,仅Meta一家所拥有的英伟达高端芯片的数量,就超过了国内所有头部大厂之和。

仅凭DeepSeek一家的创新,依然无法改变中美绝对算力存在巨大差距的事实,显然不能因为DeepSeek的目前在开源模型上的领先就认为硅谷AI大厂们遇到了“资源诅咒”,这显然是不客观的。

7.AI的“消费型内容时代”已经来了!

什么意思?以DeepSeek R1为代表的高阶AI,在内容创作层面已经接近通过“艺术家图灵测试”。

即人们已经区分不了这些文字到底是AI生成的还是艺术家创作的,这就是标志着“消费型内容时代”到来。

“AI消费型内容时代”意味着很多,意味着文艺逐渐进入“乱纪元”的新阶段,意味着旧的创意体系和生产结构会逐步瓦解,意味着内容领域依赖人“原创+优质+高频”的不可能三角开始松动,意味着复合科技和人文的“π”型人才可能比单一的“T”型人才拥有更多的结构性优势,意味着很多很多.....

但无论如何,人和人的创意,依然是一切内容生产的起点。

记住,AI不会没有起点地自动工作,而人的创意指令永远是AI创造的起点,事实上,这篇文章的诞生也源于一个有意思的问题。

8.面对DeepSeek R1这种开挂的高阶AI,普通人的策略还是两个字——多用

很显然,我们之前对常规AI所积累的具体技巧,在面对R1的高阶AI大概率会失效,但如何清晰表达、如何按贝叶斯公式迭代的总原则是不变的。

这就像是做菜,放盐尝一口,放多了再加水,试多了自然知道火候。

我看过太多例子,一个新工具出来,随便试一次,发现结果不符合预期,然后就得出一个结论——“也就那样”,从此再也不碰了。

事实上,面对DeepSeek R1这的模型,输出效果不好,大概率是我们的问题,而不是它的问题。

我媳妇儿之前用Midjourney画图死活搞不出复古胶片感,后来硬是试出“1990年柯达褪色+漏光”这种奇葩关键词,Midjourney立马给跪。

说白了,再牛逼的模型本质上就跟你家狗子一样,处久了就能听懂你的各种指令,但首先你得天天带它遛弯。

9.从DeepSeek发布节奏看,它没有发布的东西可能更值得期待

很少有人注意到DeepSeek的发布节奏,12月26日发布V3,1月20日发布R1,二者相隔的时间仅仅24天。

我不知道这个公司的发布节奏是如何的决策的,但可以肯定,它显然没有有OpenAI每次发布会精准阻击Google所表现出的鸡贼,更没有山姆奥特曼每次为了融资在Twitter含糊其辞的放风,有的只有优雅的论文和爽快上架的开挂模型。

而一个合理的猜测是,DeepSeek因为有足够的技术储备从而可以无视常规的发布节奏。

从这个意义上,DeepSeek那个平均年龄25岁、人数仅100+的年轻团队在2025年还会给产业界带来哪些新的东西,由衷值得期待。

10.梁文锋大概率被低估

当Marc Andreessen、Satya Nadella、Yann LeCun等硅谷顶级大佬将DeepSeek视为"东方神秘力量"时,实质是承认中国团队开始参与定义技术演进方向,而非单纯应用落地。

梁文锋的独特性,在于其同时具备量化投资的系统思维、本土的务实精神以及硅谷式技术理想主义,而DeepSeek的MLA架构和MoE稀疏结构,标志着大模型领域首次由国内团队完成底层注意力机制革新。

品玩的骆轶航老师在一篇长文中认为将DeepSeek比喻成“AI界的拼多多”是有失偏颇的,我认为这个说法是有洞见的,DeepSeek和梁文锋显然无法简单标签化。

即刻网友@Chris-Su说,梁文锋是极少数还没被‘广泛解读和学习’的顶级CEO,的确,这几天硅谷媒体在逐句翻译和研究梁文锋的两篇采访稿,而美国电视台CNBC做了一个长达40分钟的专题片来专门讨论DeepSeek。

据我所知,这在国内技术发展史上是从来没有过的事。

从这个意义上,已经是爽文男主角的梁文锋大概率还是被低估了。

结语

我用2023年DeepSeek成立发布做大模型公告时,引用法国新浪潮导演特吕弗的一句话结束今天的文章——

“务必要疯狂地怀抱雄心,且还要疯狂地真诚。”